|

|

Новости

Статьи

Магазин

Драйвера

Контакты

RSS канал новостей

Программаторы 25 SPI FLASH

Адаптеры Optibay HDD Caddy

Драйвера nVidia GeForce

Драйвера AMD Radeon HD

Игры на DVD

Сравнение видеокарт

Сравнение процессоров

В конце марта компания ASRock анонсировала фирменную линейку графических ускорителей Phantom Gaming. ... Компания Huawei продолжает заниматься расширением фирменной линейки смартфонов Y Series. Очередное ... Компания Antec в своем очередном пресс-релизе анонсировала поставки фирменной серии блоков питания ... Компания Thermalright отчиталась о готовности нового высокопроизводительного процессорного кулера ... Компания Biostar сообщает в официальном пресс-релизе о готовности флагманской материнской платы ... |

АРХИВ СТАТЕЙ ЖУРНАЛА «МОЙ КОМПЬЮТЕР» ЗА 2002 ГОДGeForceFX: назад в будущее

Валерий АКСАК aksak@mycomp.com.ua Недолго музыка играла. В смысле, недолго компания ATI почивала на вершине славы с титулом «Разработчик Самого Быстрого Видеоускорителя». Ее главный конкурент —nVidia — сделал долгожданный ответный шаг, «отправив на золото» свое последнее достижение — чип NV30, он же GeForce FX. На этом предлагаю закончить сие никому не нужное пафосное вступление и перейти непосредственно к обзору горячей новинки. Ще не вмер 3Dfx? Официальный анонс GeForce FX состоялся 18 ноября 2002 года. До этого дня вся продвинутая компьютерная общественность называла новое детище nVidia просто NV30, судорожно пытаясь предугадать очередной ход искусных (впрочем, после появления линейки GeForce 4 MX4xx это, мягко говоря, довольно спорное утверждение) маркетологов компании. Будет ли это очередной GeForce (предположительно GeForce 5)? Или компания заложит фундамент нового бренда? А, быть может, решит возродить из пепла линейку TNT :-)? Подобные досужие домыслы nVidia погасила просто и элегантно, вложив в конечное название готового чипа (рис. 1) даже некоторый философский подтекст. Помните, как несколько лет назад борцы за справедливость гневно сокрушались о безвременной кончине легендарной 3Dfx и срамили «подлую» nVidia за ее «неблагородный» поступок? Как оказалось, полупроводниковый гигант не так уж плох, как его хотели бы видеть «знатоки» современного IT-рынка. После того, как nVidia поглотила (называть тот процесс «слиянием» язык не поворачивается) основательно забуксовавшую и запутавшуюся в собственных обещаниях 3Dfx, она не стала отказываться от знаний и имеющихся наработок бывших сотрудников поверженного конкурента, а поставила их себе в актив. Как результат — большая часть концепт-плана так и не осуществленного проекта 3Dfx под кодовым названием Mojo стала основой разработки нового чипа nVidia, который называется… Да-да, именно GeForce FX (рис. 2). Поэтому имеем все основания предположить, что символы «FX» в названии новой линейки чипов поставлены не только для выделения ее из массивной группы всяческих GeForce 2, 3 и 4 и отнюдь не означают поддержу каких-либо потрясающих спецэффектов. И вполне понятно, почему nVidia решила не трогать свой самый успешный GPU-бренд, а просто в очередной раз переработала индекс возле его названия — кто ж будет добровольно убивать курицу, несущую золотые яйца? Тем более, что по данным все тех же маркетологов все той же nVidia, конечным потребителям ее продукции лейбл «GeForce» куда более известен, нежели имя «nVidia».

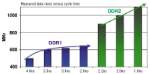

Новый чип, по замыслу разработчиков, должен стать новым флагманом nVidia, оттеснив на задний план предыдущего hi-end-лидера — GeForce 4 Titanium 4600. При этом видеокарты на основе GeForce FX займут ту же ценовую нишу, что сейчас «оккупировал» ATI Radeon 9700, демонстрируя при этом значительное превосходство как в скорости (по утверждению nVidia — порядка 30% в пользу GeForce FX), так и в оснащенности (об этом немного позже). Подобная ситуация должна благотворно сказаться для нас с вами как на ценах видеокарт более низкого уровня (тех же Radeon 8500/9000 и GeForce 4 Ti4600/4400/4200), так и на стоимости Radeon 9700. Ведь если инженеры nVidia не просто разбрасывают пустые обещания, то ATI придется сбросить цену на эту модель из-за нецелесообразности требовать такие же деньги за менее продвинутый продукт. Весь из себя Посмотрим, что же из себя представляет GeForce FX (рис. 3). Рассмотрим его основные характеристики, которые наверняка заинтересуют наших читателей. Чип изготавливается по 0.13-микронной технологии (GeForce 4 и Radeon 9700 — 0.15 микрон) на основе медных соединений. Подобная утонченность технологий, в первую очень, продиктована увеличением тактовой частоты графического процессора и практически двукратным ростом числа используемых в чипе транзисторов. Данный подход позволил максимально сократить тепловыделение GPU, но все равно система охлаждения видеокарт на основе GeForce FX представляет из себя нечто особенное, поэтому чуть позже Число транзисторов чипа GeForce FX — 125 миллионов (GeForce 4 Ti4600 — 68 млн., Radeon 9700 — 107 млн.). Частота графического ядра — 500 МГц (GeForce 4 Ti4600 — 300 МГц, Radeon 9700 — 300 МГц). Используется 128-битная DDRII-память частотой 1 ГГц (1000 МГц!) (Radeon 9700 — 256-битная DDR 600 МГц). Системный интерфейс — AGP 3.0 (AGP 8X). При этом карты на основе GeForce FX должны обладать обратной совместимостью с предыдущими версиями AGP (4X, 2X). Два встроенных RAMDAC частотой 400 МГц. Встроенный интерфейс для внешнего TV-OUT-чипа. 3 геометрических процессора. 8 пиксельных процессоров. Гибко конфигурируемый массив из 8 конвейеризованных фильтрующих текстуры блоков вычисляет до 8-ми выбранных и отфильтрованных результатов за такт. Четырехканальный контроллер памяти с коммутатором. Полноценная поддержка всех функций DirectX 9 (включая поддержку вершинных и пиксельных шейдеров версии 2.0+). Развитая система экономии пропускной полосы локальной памяти (полное сжатие буфера кадра). Благодаря данной функции появились новые преимущества в организации полноэкранного сглаживания. Тайловые оптимизации (кэширование, сжатие и отсечение невидимых поверхностей). Новый оптимизированный алгоритм анизотропной фильтрации, с минимальным падением FPS при активации. Режимы анизотропии — до 8Х включительно. Установка желаемого режима фильтрации теперь происходит более гибко, за счет предоставления нескольких градаций между стандартными значениями. Таким образом, каждый пользователь без жестких ограничений может подобрать удовлетворяющий его систему режим. Новые режимы антиалиасинга 8Х (DirectX и OpenGL) и 6ХS (DirectX). Обе функции не являются чем-то кардинально новым и отличаются от привычных режимов только масштабом деления пикселей на семплы. Обобщенный пакет кинематографических технологий CineFX. Полноценная поддержка 16-битных и 32-битных компонент с 32-х, 64-х и 128-битной точностью цвета. Кроме всего этого, в чипе есть еще много интересных новинок, но многие из них по своей специфике выходят за рамки темы данной статьи, поэтому предлагаю всем желающим заглянуть на русскоязычный сайт компании nVidia (http://www.nvidia.ru) и скачать в соответствующем разделе нужные мануалы в виде PDF-файлов. Сразу предупреждаю, что их размеры «кусаются» — один файл весит более одного, а то и двух мегабайт. Как мы заметили выше, столь мощному чипу характерен соответствующий уровень тепловыделения. Все уже давно привыкли, что для предотвращения перегрева видеокарты используется специальная система охлаждения — кулер (радиатор с вентилятором) на самом графическом процессоре и радиаторы на чипах памяти. Но то, что представила компания nVidia журналистам на московской презентации GeForce FX… Посмотрите на этот рисунок (рис. 4), и вам станет понятно, о чем я говорю. Ну что? Впечатляет? Впрочем, не все так страшно, как кажется на первый взгляд. Во-первых, то чудо, что вы видите на изображении, является ultra-вариантом (другими словами, карта по умолчанию разогнана и оснащена высококачественными комплектующими для стабильной работы на повышенных частотах). Нормальные варианты карт (работающие на частотах, согласованных с официальными спецификациями) на основе GeForce FX, судя по всему, будут комплектоваться стандартными на сегодняшний день системами охлаждения (может быть, чуть усложненными вариантами) или облегченными конструкциями подобных турбинных установок. То же касается и урезанных вариантов чипа, которые уже традиционно можно ожидать от Во-вторых, графический процессор оснащен специальными термодатчиками, на основании показаний которых видеокарта автоматически регулирует скорость вращения вентилятора. Поэтому, если вы просто хотите послушать музыку, можно не опасаться, что шум кулера на видеокарте заглушит грохочущий из ваших колонок Rammstein. Приятное нововведение, согласитесь. Остается надеяться, что подобную технологию смогут внедрить в свои чипы и другие разработчики. Отдельного внимания заслуживает новая система видеопамяти. Использование DDRII открывает перед разработчиками готовых видеокарт и чипов памяти новый уровень рабочих частот (рис. 5), что не может не радовать. Мы-то с вами давно знаем, что в современных видеокартах память — одно из самых «узких мест» в общей системе производительности устройства. Хочется надеяться, что теперь ситуация изменится к лучшему. Кроме высокой производительности, DDRII-память обладает и другими очень полезными характеристиками:

в какой-то мере снижает стоимость и уменьшает габариты корпуса видеочипа; имеет более помехоустойчивый интерфейс и значительно меньшее время доступа. В перспективе применение DDRII ведет к снижению стоимости видеокарт. К сожалению, GeForce FX использует только 128-битную шину доступа к видеопамяти, при возможной 256-битной. Но это вполне оправданный маркетинговый и инженерный ход (тут, как говорится, рука руку моет). Зато можно с уверенностью утверждать, что GeForce FX есть куда расти. Пока же пиковая полоса пропускания памяти на данных видеокартах будет составлять 16 Гб/с, при 20 Гб/с — у Radeon 9700. При этом нельзя не упомянуть, что благодаря третей версии системы Lightspeed Memory Architecture теоретически потенциальный показатель пиковой пропускной способности памяти на GeForce FX может достигать 48 Гб/с! Чего же ждать нам от него? Внушающие показатели частот, объемов, наворотов… А как же эта гремучая смесь смотрится в реальных приложениях? Как показали тестирования на московской презентации, GeForce FX демонстрирует результаты, достойные выданных ему солидных авансов. Живой пример: в Quake 3 в разрешении 2048х1536 GeForce 4 Ti4600 (чувствуете эту мощь, да?) показал 93.9 кадров в секунду, GeForce FX — 173.1 FPS. Практически двукратное преимущество новичка внушает уважение. Вы скажете, что Quake 3 — старая игра, и я с вами соглашусь. Поэтому приведу более злободневные цифры: по данным nVidia, в грядущем Doom III GeForce 4 Ti4600 выдавит из себя несчастные 20 FPS, которых с горем пополам хватит, чтобы хотя как-нибудь сориентироваться в пространстве, GeForce FX — порядка 50 кадров. Вдобавок к этому скажу, что посетители презентации получили уникальную возможность лицезреть на большом экране демонстрационную версию многообещающего 3D-шутера S.T.A.L.K.E.R. от киевских разработчиков (его главной особенностью является потрясающе детализированная графика с использованием реальных фототекстур, рис. 6). Так вот, она летала на GeForce FX с завидным Уже слышу крики по ту сторону журнала: «ХОЧУ!!!». Хотеть не вредно только в том случае, если вы найдете $400 на стандартную модель или $500 — на ultra. Ориентировочная стоимость ориентировочного лидера рынка видеокарт ориентировочно именно такова :-). Рекомендуем ещё прочитать:

|

|

|

| Хостинг на серверах в Украине, США и Германии. | © sector.biz.ua 2006-2015 design by Vadim Popov |

nVidia.

nVidia.

Идёт загрузка...

Идёт загрузка...